Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Технологические гиганты каждый день используют многомодальный RAG в производстве!

- Spotify использует его для ответов на музыкальные запросы

- YouTube использует его для превращения подсказок в треки

- Amazon Music использует его для создания плейлистов по подсказке

Давайте научимся, как построить многомодальный агентный RAG (с кодом):

Сегодня мы создадим многомодальный агентный RAG, который сможет запрашивать документы и аудиофайлы с помощью речи пользователя.

Технологический стек:

- @AssemblyAI для транскрипции.

- @milvusio в качестве векторной базы данных.

- @beam_cloud для развертывания.

- @crewAIInc Flows для оркестрации.

Давайте создадим это!

Вот рабочий процесс:

- Пользователь вводит данные (аудио + документы).

- AssemblyAI транскрибирует аудиофайлы.

- Транскрибированный текст и документы встраиваются в векторную базу данных Milvus.

- Агент исследования извлекает информацию по запросу пользователя.

- Агент ответа использует это для составления ответа.

Проверьте это👇

1️⃣ Сбор данных

Для начала пользователь предоставляет текстовые и аудио входные данные в директории данных.

CrewAI Flow реализует логику для обнаружения файлов и подготовки их к дальнейшей обработке.

Проверьте это👇

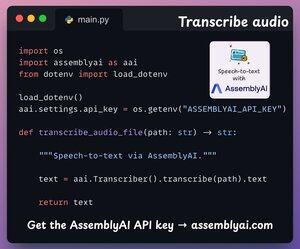

2️⃣ Транскрибировать аудио

Далее мы транскрибируем аудиоввод пользователя, используя платформу распознавания речи AssemblyAI.

AssemblyAI не является открытым исходным кодом, но предоставляет достаточно бесплатных кредитов для использования своих моделей транскрипции SOTA, что более чем достаточно для этой демонстрации.

Проверьте это👇

3️⃣ Встраивание входных данных

Далее, транскрибированные входные данные из предыдущего шага и текстовые данные вводятся и хранятся в векторной базе данных Milvus.

Вот как мы это делаем 👇

4️⃣ Запрос пользователя

Загрузка завершена.

Теперь мы переходим к фазе вывода!

Далее пользователь вводит голосовой запрос, который транскрибируется с помощью AssemblyAI.

Проверьте это👇

5️⃣ Получите контекст

Затем мы создаем вектор для запроса и извлекаем наиболее релевантные фрагменты из векторной базы данных Milvus.

Вот как мы это делаем 👇

6️⃣ Сгенерировать ответ

Как только у нас есть соответствующий контекст, наша команда вызывается для генерации четкого и обоснованного ответа для пользователя.

Проверьте это 👇

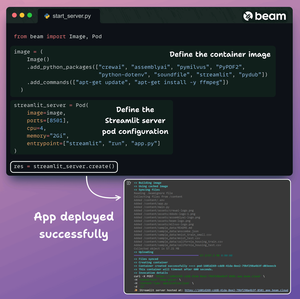

Наконец, мы собираем все в чистый интерфейс Streamlit и разворачиваем приложение в безсерверном контейнере с использованием Beam.

Мы импортируем необходимые зависимости Python и указываем вычислительные характеристики для контейнера.

А затем мы разворачиваем приложение всего в несколько строк кода👇

После развертывания мы получаем 100% частное развертывание для многомодального рабочего процесса RAG Agentic, который мы только что создали.

Посмотрите эту демонстрацию 👇

Вот рабочий процесс, который мы реализовали:

- Пользователь предоставил данные (аудио + документы)

- AssemblyAI транскрибировал аудиофайлы

- Транскрибированные данные встроены в векторную базу данных

- Исследовательский агент извлек информацию по запросу пользователя

- Агент ответа использовал это для составления ответа

Проверьте это👇

Если вы нашли это полезным, поделитесь с вашей сетью.

Найдите меня → @akshay_pachaar ✔️

Для получения дополнительных сведений и учебных материалов по LLM, AI-агентам и машинному обучению!

5 авг., 20:30

Технологические гиганты каждый день используют многомодальный RAG в производстве!

- Spotify использует его для ответов на музыкальные запросы

- YouTube использует его для превращения подсказок в треки

- Amazon Music использует его для создания плейлистов по подсказке

Давайте научимся, как построить многомодальный агентный RAG (с кодом):

106,57K

Топ

Рейтинг

Избранное