トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

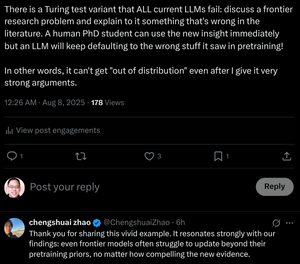

「フロンティアモデルでさえ、新しい証拠がどれほど説得力があるとしても、事前学習の事前確率を超えて更新するのに苦労しています。」

私たちはこれを行うために博士課程の学生を訓練します!変圧器は重量を変えずにそれを行うことができますか?

8月8日 07:29

LLM の思考連鎖推論は蜃気楼ですか?

...私たちの結果は、CoT推論がもろい蜃気楼であり、トレーニング分布を超えて押し出されると消えることを示しています。この研究は、CoT 推論が失敗する理由と時期についてのより深い理解を提供し、真の一般化可能な推論を達成するという継続的な課題を強調します。

...私たちの調査結果は、CoT推論が分布内または近傍に適用されたときに効果的に機能することを示しています

分布内データですが、中程度の分布シフト下でも壊れやすく、障害が発生しやすくなります。

場合によっては、LLM は流暢ではあるが論理的に一貫性のない推論ステップを生成します。この結果は、構造化された推論のように見えるものが、論理的な推論ではなく、トレーニングデータの記憶または補間されたパターンから浮かび上がる蜃気楼である可能性があることを示唆しています。

...これらの発見を総合すると、LLM は原則に基づいた推論者ではなく、推論のようなテキストの洗練されたシミュレーターであることを示唆しています。

13K

トップ

ランキング

お気に入り