Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

CodecFlow

Utførelseslag for AI-operatører og robotikk på @Solana

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

VLA-er er fortsatt veldig nye, og mange synes det er vanskelig å forstå forskjellen mellom VLA-er og LLM-er.

Her er et dypdykk i hvordan disse AI-systemene er forskjellige i resonnement, sensing og handling. Del 1.

La oss bryte ned de viktigste forskjellene og hvordan AI-agenter pakket rundt en LLM skiller seg fra operatøragenter som bruker VLA-modeller:

1. Sans: Hvordan de oppfatter verden

Agent (LLM): Behandler tekst eller strukturerte data, for eksempel JSON, APIer og noen ganger bilder. Det er som en hjerne som jobber med rene, abstraherte inndata. Tenk å lese en håndbok eller analysere et regneark. Flott for strukturerte miljøer, men begrenset av hva som mates til det.

Operator (VLA): Ser rå piksler i sanntid fra kameraer, pluss sensordata (f.eks. berøring, posisjon) og propriosepsjon (selvbevissthet om bevegelse). Det er som å navigere i verden med øyne og sanser, og trives i dynamiske, rotete omgivelser som brukergrensesnitt eller fysiske rom.

2. Handling: Hvordan de samhandler

Agent: Fungerer ved å kalle funksjoner, verktøy eller API-er. Tenk deg det som en leder som sender nøyaktige instruksjoner som «bestill en flyreise via Expedia API». Det er bevisst, men er avhengig av forhåndsbygde verktøy og klare grensesnitt.

Operatør: Utfører kontinuerlige handlinger på lavt nivå, som å flytte en musepeker, skrive eller kontrollere robotledd. Det er som en dyktig arbeider som direkte manipulerer miljøet, ideelt for oppgaver som krever sanntidspresisjon.

3. Kontroll: Hvordan de tar beslutninger

Agent: Følger en langsom, reflekterende sløyfe: planlegg, ring et verktøy, evaluer resultatet, gjenta. Den er tokenbundet (begrenset av tekstbehandling) og nettverksbundet (venter på API-svar). Dette gjør det metodisk, men tregt for sanntidsoppgaver.

Operatør: Opererer, tar trinnvise beslutninger i en tett tilbakemeldingssløyfe. Tenk på det som en spiller som reagerer umiddelbart på det som er på skjermen. Denne hastigheten muliggjør væskeinteraksjon, men krever robust sanntidsbehandling.

4. Data å lære: Hva driver opplæringen deres

Agent: Opplært på store tekstkorpus, instruksjoner, dokumentasjon eller RAG-datasett (Retrieval-Augmented Generation). Den lærer av bøker, kode eller vanlige spørsmål, og utmerker seg ved å resonnere fremfor strukturert kunnskap.

Operatør: Lærer av demonstrasjoner (f.eks. videoer av mennesker som utfører oppgaver), teleoperasjonslogger eller belønningssignaler. Det er som å lære ved å se og øve, perfekt for oppgaver der det er lite eksplisitte instruksjoner.

5. Feilmoduser: Hvor de går i stykker

Agent: Utsatt for hallusinasjoner (finne på svar) eller sprø langsiktige planer som faller fra hverandre hvis ett skritt mislykkes. Det er som en strateg som overtenker eller feiltolker situasjonen.

Operatør: Står overfor kovariatforskyvning (når treningsdata ikke samsvarer med virkelige forhold) eller sammensatte feil i kontrollen (små feil snøball). Det er som en sjåfør som mister kontrollen på en ukjent vei.

6. Infra: Teknologien bak dem

Agent: Er avhengig av en ledetekst/ruter for å bestemme hvilke verktøy som skal kalles, et verktøyregister for tilgjengelige funksjoner og minne/RAG for kontekst. Det er et modulært oppsett, som et kommandosenter som orkestrerer oppgaver.

Operatør: Trenger pipeliner for videoinntak, en handlingsserver for sanntidskontroll, et sikkerhetsskjold for å forhindre skadelige handlinger og en repetisjonsbuffer for å lagre opplevelser. Det er et høyytelsessystem bygget for dynamiske miljøer.

7. Hvor hver skinner: Deres søte flekker

Agent: Dominerer i arbeidsflyter med rene APIer (f.eks. automatisering av forretningsprosesser), resonnement over dokumenter (f.eks. oppsummering av rapporter) eller kodegenerering. Det er din favoritt for strukturerte oppgaver på høyt nivå.

Operatør: Utmerker seg i rotete, API-løse miljøer som å navigere i klønete brukergrensesnitt, kontrollere roboter eller takle spilllignende oppgaver. Hvis det involverer sanntidsinteraksjon med uforutsigbare systemer, er VLA konge.

8. Mental modell: Planlegger + Doer

Tenk på LLM-agenten som planleggeren: den deler komplekse oppgaver inn i klare, logiske mål.

VLA-operatøren er den som utfører disse målene ved å samhandle direkte med piksler eller fysiske systemer. En kontrollør (et annet system eller agent) overvåker resultatene for å sikre suksess.

$CODEC

14,15K

Codecflow Optr tilbyr en enhetlig tilnærming til å bygge agenter som ser, resonnerer og handler i digitale og fysiske miljøer. Enten den automatiserer skrivebordsarbeidsflyter, kontrollerer robotarmer eller tester i simulering, bruker den samme mentale modell og primitiver.

Louround 🥂21. aug., 04:10

Fall i et oksemarked er ment å kjøpes, spesielt på prosjekter med store katalysatorer

Vi vet alle at AI er fortellingen om denne syklusen, startet av ai16z og Virtuals i fjor.

Min innsats er at markedet vil fokusere på mer komplekse og sofistikerte teknologier som VLA-er, og la meg fortelle deg hvorfor.

LLM-er (Large Language Models) leser og skriver hovedsakelig tekst: de er flinke til å forklare, planlegge og generere instruksjoner, men de styrer ikke i seg selv motorer eller samhandler med den fysiske verden (som du kanskje har opplevd med chatgpt).

VLA-er (Vision Language Action-modeller) skiller seg fra LLM-er ettersom de er multimodale systemer som ser på ting (syn), forstår instruksjoner (språk) og direkte produserer handlinger. Det er som å be en robot om å plukke opp en rød kopp og deretter bevege armen for å gjøre det.

VLA-er er trent på eksempler som parer bilder/video + instruksjoner + virkelige handlingsspor (hvordan en robot faktisk beveget seg), og de må løpe raskt og trygt i sanntid. LLM-er på sin side er opplært på enorme tekstsamlinger og fokuserer på resonnement og språkoppgaver.

TL; DR LLM-er tenker og snakker når VLA-er ser, resonnerer og handler.

Som du kan se, er VLA-er et viktig tillegg til LLM-er og vil spesielt muliggjøre den neste 0 til 1-innovasjonen i den totale økonomien som vil være robotikk. Et flertall av investeringsfondene allokerer en stor del av investeringene sine til denne sektoren, sett på som den neste logiske utviklingen i AI-industrien.

Jeg har allerede laget et innlegg for en stund siden om den nåværende lederen i kryptomarkedet, @codecopenflow, som ikke samlet inn kapital (rettferdig lansering), men som likevel sender banebrytende produkter og for tiden ligger på 23 millioner dollar FDV.

For informasjon samlet andre kryptokonkurrenter inn 20 millioner dollar (@openmind_agi) til det som sannsynligvis er en FDV på 200 til 300 millioner dollar ++ mens ingen produkter eller fellesskap er bygget og sendt ennå.

Det som gjør Codec til et ledende prosjekt i sektoren er at de takler en avgjørende flaskehals innen robotikk og AI, som er vanskeligheten med å få alle AI-verktøyene til å samhandle sammen. La meg forklare.

Deres siste utgivelse, OPTR (operator), er et verktøysett som hjelper til med å bygge operatører som er i stand til å samhandle på flere plattformer som roboter, stasjonære datamaskiner, nettlesere eller simuleringer. Målet til en operatør er å se, resonnere og handle (VLA) i både digitale (datamaskiner) og fysiske (roboter) verdener.

Dette verktøysettet fungerer som kjerneinfrastruktur for robotteam som tar sikte på å teste produktet sitt og forbedre den generelle prosessen ved å gi en enhetlig opplevelse i stedet for separate for nettlesere, simuleringer eller roboter. Dette gjør i hovedsak operatøren tilpasningsdyktig og autonom uavhengig av omgivelsene.

Så du skjønner det, det vil spare mye tid for selskaper og utviklere som tidligere måtte gå gjennom hvert trinn manuelt, og hvor du kan spare tid kan du spare penger.

Det vil også gjøre det mulig for Codec å bygge sine egne operatørprosjekter og lansere nye kapasiteter relativt raskt på markedet, spesielt gjennom deres markedsplass.

TL; DR: Du har sikkert sett videoer av roboter som bretter vev, sorterer bokser eller hopper på forskjellige elementer. De har alle fått opplæring for dette svært spesifikke brukstilfellet, og dessverre kan ikke en ferdighet gjenbrukes i et annet miljø slik et menneske kan gjøre. OPTR fra Codec løser dette ved å gjøre ferdigheter overførbare mellom miljøer og situasjoner, noe som gjør opplæring og utvikling mye raskere og billigere for bedrifter.

Dette er grunnen til at Codec er så interessant for å forene den digitale verden med den fysiske verden.

$CODEC, kodet.

1,84K

Forskningsfirmaet @epochbiz (av @ZoomerOracle) publiserte en detaljert forskningsartikkel om CodecFlow.

Ikke gå glipp av det.

$CODEC

epoch_19. aug., 21:07

$CODEC er satt opp til å være det beste alternativet som onchain-spill for robotikk

Forskningsartikkel om @codecopenflow er nå publisert 🤖

3,18K

Vi ser en økning i falske kontoer som hevder å representere CodecFlow.

Den eneste offisielle X/Twitter er @codecopenflow og @RoboMove.

Alle andre verifiserte kanaler er oppført på nettstedet vårt.

Det er bare ett token, $CODEC.

Vær årvåken og rapporter mistenkelige kontoer.

Vennligst repost og del for å spre ordet.

3,11K

RoboMove er et utstillingsvindu drevet utelukkende av CodecFlow-infrastruktur.

Det er ikke noe eget token. $CODEC er det eneste tokenet i økosystemet.

@RoboMove er bare ett eksempel på hva som er mulig med CodecFlow Operators.

Snart vil utviklere kunne bygge sine egne avanserte systemer på CodecFlow ved hjelp av vår SDK og verktøy.

Plattformen er med vilje åpen og utvidbar, noe som tillater endeløse brukstilfeller fra robotkontroll til GUI-automatisering.

⚠️ Ikke fall for falske tokens eller imitatorer. Bekreft alltid fra offisielle kilder.

3,64K

Vi er glade for å se at det kinesiske samfunnet legger merke til CodecFlow og elsker det vi bygger.

Velkommen. Vi har bare så vidt begynt. Mye mer kommer.

0xFunky13. juli 2025

PUMP-salget er over, opprinnelig var jeg også et stort beløp i Bybit, bare 1/2 på kjeden, og til slutt var det bare kjeden som var vellykket, heldigvis var det ingen sikring på forhånd...

Den siste tiden har det vært mye diskusjon i AI-miljøet om VLA (Vision-Language-Action)

Spesielt gikk jeg for å undersøke om det var noen som drev med VLA-relaterte prosjekter i kjeden, og jeg så dette CodecFlow@Codecopenflow prosjektet og kjøpte litt.

== Hva gjør CodecFlow ==

En kort introduksjon til VLA, en modellarkitektur som lar AI ikke bare "snakke", men "gjøre".

Tradisjonelle LLM-er (som GPT) kan bare forstå språk og gi forslag, men den kan ikke gjøre praktisk, klikke på skjermer eller ta tak i objekter.

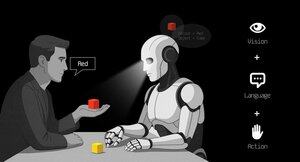

VLA-modellen betyr at den integrerer tre funksjoner:

1. Visjon: Forstå bilder, skjermbilder, kamerainnganger eller sensordata

2. Språk: Forstå menneskelige naturlige språkinstruksjoner

3. Handling: Generer kjørbare kommandoer, for eksempel museklikk, tastaturinngang og kontroll av robotarmen

CodecFlow gjør VLA på kjeden, og alle prosessene kan også lastes opp til kjeden, som kan revideres, verifiseres og avgjøres.

Enkelt sagt er det infrastrukturen til en "AI-bot".

== Hvorfor er jeg spesielt oppmerksom på dette elementet? ==

Jeg fant ut at utviklerne deres er kjernebidragsytere til LeRobot, det hotteste åpen kildekode-prosjektet i VLA-området!

LeRobot er den beste basen for å bygge VLA-modeller i åpen kildekode-verdenen, inkludert lette VLA-er som kan kjøres på bærbare datamaskiner som SmolVLA.

Det betyr at dette teamet virkelig forstår VlA-arkitektur og robot.

Jeg ser at de også fortsetter å bygge, og prisen på valutaen stiger også jevnt og trutt, jeg er veldig optimistisk med tanke på VLA-sporet, og fra den generelle trenden er VLA og roboter faktisk fremtiden i markedet.

• Web2-giganter (Google, Meta, Tesla) er nå fullt forpliktet til VLA og bottrening;

• Web3-prosjekter er knappe når det gjelder VLA-applikasjoner som kan utføre oppgaver

• VLA har muligheten til å spille en stor rolle i scenarier som DePIN, Web Automation og utførelse av AI-agenter på kjeden.

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Alltid DYOR。

3,9K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til