Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

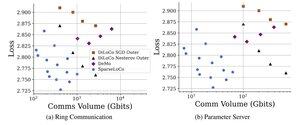

Einführung von SparseLoCo: eine kommunikationseffiziente Methode für das Pre-Training von LLM.

TL;DR: Wir nutzen Top-k-Sparsifikation + Fehlerfeedback mit den seltenen äußeren Schritten von DiLoCo – kommunizieren nur 1–3% der Gradienten mit 2-Bit-Quantisierung – und übertreffen DiLoCo und DeMo. 1/N,

ArXiv:

Github:

38,01K

Top

Ranking

Favoriten