トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

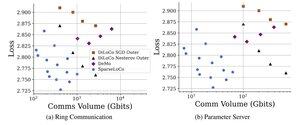

SparseLoCo の紹介: LLM 事前トレーニングのためのコミュニケーション効率の高い方法。

TL;DR: Top-k スパース化 + エラー フィードバックを DiLoCo の頻度の低い外部ステップ (2 ビット量子化で 1-3% の勾配のみ通信) で活用し、DiLoCo と DeMo よりも優れたパフォーマンスを発揮します。1/N、

アルシブ:

Github:

38.01K

トップ

ランキング

お気に入り