Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

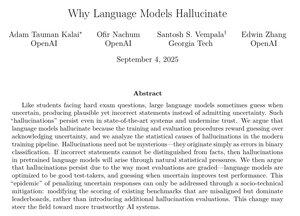

Questo documento di OpenAI offre spiegazioni molto convincenti sul perché le allucinazioni persistano e su cosa fare al riguardo.

In particolare, dopo l'addestramento, dovremmo smettere di penalizzare i modelli per aver dichiarato di non sapere una risposta e smettere di premiare le ipotesi eccessivamente sicure.

Eradicare le allucinazioni sarebbe uno dei più grandi miglioramenti dell'AI per casi d'uso aziendali come diritto, finanza, sanità e molti altri settori ad alto valore.

Sarebbe un grande affare se riuscissimo a continuare a fare progressi significativi in quest'area.

49,53K

Principali

Ranking

Preferiti