Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Bonito, me encanta verlo.

Algunas preguntas en mi mente:

* ¿Qué configuración del sistema preferiría la comunicación dispersa en lugar de la transmisión de Diloco? ¿Qué pasa si los combinas?

* ¿Es SparseLoCo obteniendo una pérdida más baja a veces un artefacto de variación aleatoria, o podemos hacer pruebas de hipótesis reales sobre este resultado?

* La retroalimentación de errores es un operador sesgado: ¿hay otras operaciones sesgadas que puedan mejorar la optimización externa?

22 ago, 10:13

Presentamos SparseLoCo: un método eficiente en la comunicación para el preentrenamiento de LLM.

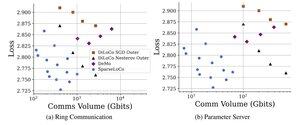

TL; DR: Aprovechamos la esparsificación Top-k + retroalimentación de errores con los pasos externos poco frecuentes de DiLoCo, que comunican solo gradientes del 1 al 3% con cuantificación de 2 bits, superando a DiLoCo y DeMo. 1/N,

ArXiv:

Github:

1.3K

Populares

Ranking

Favoritas