Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Приємно, люблю це бачити.

Декілька запитань, які у мене в голові:

* Яким системним налаштуванням віддали б перевагу розріджений зв'язок перед потоковим Diloco? Що буде, якщо їх поєднати?

* Чи є отримання SparseLoCo нижчих втрат іноді артефактом випадкової варіації, чи ми можемо провести фактичну перевірку гіпотез щодо цього результату?

* Зворотний зв'язок по помилках є упередженим оператором - чи існують інші упереджені операції, які можуть поліпшити зовнішню оптимізацію?

22 серп., 10:13

Представляємо SparseLoCo: комунікативно-ефективний метод для попереднього навчання LLM.

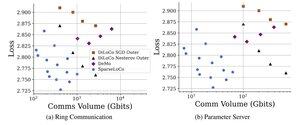

ТЛ; Д.Р.: Ми використовуємо розрідження Top-k + зворотний зв'язок по помилках з нечастими зовнішніми кроками DiLoCo - передача лише 1-3% градієнтів з 2-бітною квантуванням - перевершуючи DiLoCo і DeMo. 1/Н,

ArXiv:

На Github:

1,28K

Найкращі

Рейтинг

Вибране