Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Pěkné, rád to vidím.

Několik otázek na mysli:

* Jaká nastavení systému by upřednostňovala řídkou komunikaci oproti streamování Diloco? Co se stane, když je zkombinujete?

* Je získání nižší ztráty SparseLoCo někdy artefaktem náhodné variace, nebo můžeme provést skutečné testování hypotéz o tomto výsledku?

* Zpětná vazba o chybě je zaujatý operátor - existují další zaujaté operace, které mohou zlepšit vnější optimalizaci?

22. 8. 10:13

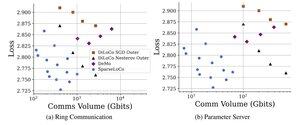

Představujeme SparseLoCo: komunikačně efektivní metodu pro předškolení LLM.

TL; DR: Využíváme Top-k sparsifikace + zpětnou vazbu o chybě s občasnými vnějšími kroky DiLoCo - komunikuje pouze 1–3% gradienty s 2-bitovou kvantizací - překonáváme DiLoCo a DeMo. 1/N,

ArXiv:

Github:

1,26K

Top

Hodnocení

Oblíbené