Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Très bon travail avec @amir_sarfi @benjamintherien et @tplr_ai

22 août, 10:13

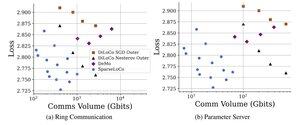

Présentation de SparseLoCo : une méthode de pré-entraînement pour LLM efficace en communication.

Résumé : Nous exploitons la sparsification Top-k + le retour d'erreur avec les étapes extérieures peu fréquentes de DiLoCo—communiquant seulement 1 à 3 % des gradients avec une quantification en 2 bits—dépassant DiLoCo et DeMo. 1/N,

ArXiv :

Github :

3,7K

Meilleurs

Classement

Favoris