Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

swyx

oppnå ambisjoner med intensjonalitet, intensitet og integritet

- @smol_ai

- @dxtipshq

- @sveltesociety

- @aidotengineer

- @coding_career

- @latentspacepod

noe utrolig ironipoetisk:

TIL at bevisene for sterk Sapir-Whorf er svake og bevisene for svake Sapir-Whorf er sterke

Dette reiser spørsmålet om:

1. Når gjør sterk overgang til svak og avtar bevisstøtte i tandem eller er det en termoklin

2. Antagelig eksisterer det mye sterksvak vs svak dynamikk med mange teorier; hvilke teorier er sterksterke OG svake? Jeg mistenker VELDIG få.

5,18K

[send til interesserte venner pls]

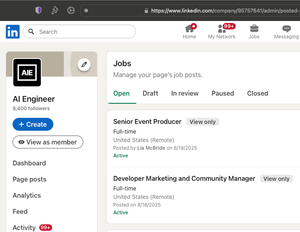

Vi utvider det @aidotengineer teamet (og vil kunngjøre vårt første høstmøte snart (19.-22. november) og deretter vår 2026-tavle og vår nye lagoppstilling.

AIE når nå over 1,1 millioner AI-ingeniører i måneden, og konferansene har ~doblet seg hvert år. Vi dobler igjen neste år. Det har hjulpet bedrifter med å ansette, og hjulpet bedrifter med å få nye jobber. Folk har til og med møtt og blitt forelsket i AIE-er (!!)

Hvis du liker å jobbe med ingeniører og ønsker å bidra til å gjøre AI Engineering til en kraft for det gode over slop, kom og bli med oss. Ting bøyde seg på en v stor måte i år (ikke overdrivelse), og vi trenger hjelp til å gjøre det til et kvalitetsfellesskap for alle interessenter fra deltakere til sponsorer til foredragsholdere til online!

hvis du er "High Agency" og ønsker å foreslå din egen rolle, info @ AI . Ingeniør fungerer, det samme gjør SWYC @

14,33K

swyx lagt ut på nytt

Greg Brockman (@gdb), medgründer og president i OpenAI, om rollen til åpne modeller for deres virksomhet (~50:20 inn i den siste Latent Space Podcast):

En annen ting på et veldig praktisk nivå som vi har tenkt på med åpen kildekode-modeller, er at folk som bygger på åpen kildekode-modellen vår, på en måte bygger på teknologistabelen vår.

Hvis du er avhengig av at vi hjelper til med å forbedre modellen, at du er avhengig av at vi får det neste gjennombruddet, så betyr det at du faktisk har en avhengighet, både på en måte som er bra for virksomheten vår, men jeg tror det også er bra for landet.

At du tenker på å ha en amerikansk teknologistabel fra modellene som folk kjører direkte. Men hvordan de kommer til å samhandle på den måten vi nettopp snakket om, som faktisk lar oss bygge et helt økosystem der folk er i stand til å ha, du vet, kontroll over de delene av det som er viktige for dem, til syvende og sist bygges på disse modellene som gjenspeiler amerikanske verdier, Umm og så være i stand til å samhandle med amerikanske, du vet, forhåpentligvis brikker under, og skymodeller på backend og utførelsesmiljøer og alt det som passer sammen, det tror jeg er noe som det tilfører mye verdi, og jeg tror det gjør det mulig for amerikansk lederskap å virkelig også bety at eh vi har lederskap i våre verdier i verden.

32,84K

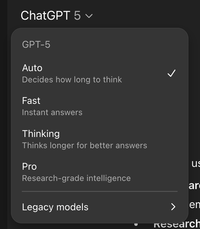

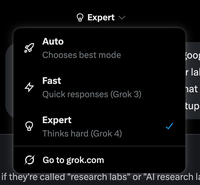

imitasjon er den oppriktige formen for smiger

(Det var raskt, @xai!)

Sam Altman13. aug., 09:19

Oppdateringer til ChatGPT:

Du kan nå velge mellom "Auto", "Fast" og "Thinking" for GPT-5. De fleste brukere vil ha Auto, men tilleggskontrollen vil være nyttig for noen mennesker.

Hastighetsgrensene er nå 3,000 meldinger/uke med GPT-5 Thinking, og deretter ekstra kapasitet på GPT-5 Thinking mini etter den grensen. Kontekstgrensen for GPT-5 Thinking er 196k tokens. Vi må kanskje oppdatere hastighetsgrenser over tid, avhengig av bruk.

4o er tilbake i modellvelgeren for alle betalte brukere som standard. Hvis vi noen gang avvikler den, vil vi gi god beskjed. Betalte brukere har nå også en "Vis flere modeller"-bryter i ChatGPT-nettinnstillingene som vil legge til modeller som o3, 4.1 og GPT-5 Thinking mini. 4.5 er bare tilgjengelig for Pro-brukere – det koster mange GPUer.

Vi jobber med en oppdatering av GPT-5s personlighet som skal føles varmere enn den nåværende personligheten, men ikke så irriterende (for de fleste brukere) som GPT-4o. En læring for oss fra de siste dagene er imidlertid at vi egentlig bare trenger å komme til en verden med mer tilpasning per bruker av modellpersonlighet.

594

åpnesourcing ChromeTabOverflow:

jeg ble lei av OoM-feil fra mine 300+ åpne Chrome-faner. tar opptil 60 GB minne og dreper produktiviteten min over hele maskinen

ingen av de tullete AI-nettleserne (jeg har prøvd alle) gjør det grunnleggende for å hjelpe deg med å organisere hundrevis av åpne faner riktig. Så laget 4 verktøy som gjør tingen.

vibekodet på 2 timer. takket være @windsurf og Claude Code

17,81K

En av de mest vedvarende lærdommene jeg har hatt fra å snakke med de øverste vertikale AI-startupene er at de er -alle- hensynsløst multimodeller. Hver modell blir testet, hver modell brukes for relativt spesifikke styrker, hvert lag har sin egen ruter. Ingen Biglab-lojalitet noe sted.

Det er inspirerende å se, men du begynner også å forstå:

1) konkurransepresset rundt ting som BigLab A som slippes rett før BigLab B

2) utviklererfaring og oppetid betyr fortsatt noe, men litt mindre siden hvis du har en god modellser, vil de gjøre det de trenger for å perfmaxx

3) hvor langt bak åpne modeller faktisk er

32,08K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til