Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

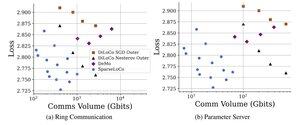

Wat als ik je vertelde hoe je DiLoCo kunt overtreffen terwijl je slechts 1-3% van de pseudogradient communiceert?

22 aug, 10:13

Introductie van SparseLoCo: een communicatie-efficiënte methode voor LLM pre-training.

TL;DR: We maken gebruik van Top-k sparsificatie + foutfeedback met DiLoCo’s onregelmatige buitenste stappen—communiceren slechts 1–3% van de gradiënten met 2-bits kwantisatie—en presteren beter dan DiLoCo en DeMo. 1/N,

ArXiv:

Github:

1,53K

Boven

Positie

Favorieten