Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Dodaj top-k + informację zwrotną o błędach i usuń zewnętrzny Nesterov z DiloCo (tak więc ~zwykły SGD).

Wciąż jestem dość zaskoczony, że to działa / może zastąpić Nesterova :0

Świetna robota!

22 sie, 10:13

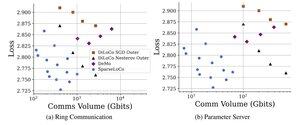

Przedstawiamy SparseLoCo: metodę efektywnej komunikacji do wstępnego szkolenia LLM.

TL;DR: Wykorzystujemy sparsifikację Top-k + sprzężenie zwrotne błędu z rzadkimi zewnętrznymi krokami DiLoCo—komunikując tylko 1–3% gradientów z kwantyzacją 2-bitową—przewyższając DiLoCo i DeMo. 1/N,

ArXiv:

Github:

4,87K

Najlepsze

Ranking

Ulubione