Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

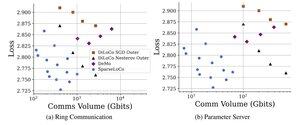

Додаємо top-k + зворотний зв'язок помилок і видаляємо зовнішні Нестерова з DiloCo (таким чином ~зовнішнє просте SGD).

Я досі дуже здивований, що він працює/міг би замінити Нестерова :0

Класна робота!

22 серп., 10:13

Представляємо SparseLoCo: комунікативно-ефективний метод для попереднього навчання LLM.

ТЛ; Д.Р.: Ми використовуємо розрідження Top-k + зворотний зв'язок по помилках з нечастими зовнішніми кроками DiLoCo - передача лише 1-3% градієнтів з 2-бітною квантуванням - перевершуючи DiLoCo і DeMo. 1/Н,

ArXiv:

На Github:

4,84K

Найкращі

Рейтинг

Вибране