熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

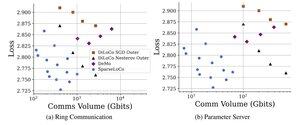

添加 top-k + 錯誤反饋,並從 DiloCo 中移除外部 Nesterov(因此大約是外部普通 SGD)。

我仍然很驚訝它能工作/可以替代 Nesterov :0

很棒的工作!

8月22日 10:13

介紹SparseLoCo:一種通信效率高的LLM預訓練方法。

簡而言之:我們利用Top-k稀疏化 + 錯誤反饋與DiLoCo的不頻繁外部步驟——僅傳遞1-3%的梯度,使用2位量化——超越了DiLoCo和DeMo。1/N,

ArXiv:

Github:

4.84K

熱門

排行

收藏